來跟風,試了一下本地端的 DeepSeek-R1:32B 模型.. (我的 GPU 勉強跑得動這大小..)

說實在話,我對他是用多少成本訓練出來的沒有很感興趣 XDD, 我在意的是能普及被每個人使用的模型能力可以到甚麼程度..

R1 對我而言, 最有參考價值的是

現在 deepseek-r1 可以本地端執行,也能看的到

-

思考過程可以降級問題的複雜度 通常你就是不懂才會問 AI,既然不懂,你應該也沒十足的把握能鑑別 AI 的回答對不對 (除非你只是故意在考他)。而看到思考過程,從中間判斷他的思路是否合理,對我而言容易得多。

-

思考過程可以提升自己的能力 之前 Lee Ruddy 老師在別的場合,提到 AI code review 會扼殺工程師學習的機會.. 我很認同老師的觀點。當然不只 code review, 各種地方過度使用, 都會讓人失去學習的能力。替代的方式是,不論你要拿 AI 來幹嘛,你都要想辦法讓自己有鑑別能力 (你要能鑑別 AI 給你的答案好不好?)。閱讀 CoT 的過程,就是個好方法,你也更有機會個別求證 (拿 think 的過程拆成小問題各自往下挖)

-

有助於進階的應用 為何我會說

內容是降級問題的複雜度? 很多人都有一套思考的方式,這些層級的思路都不會太複雜。比如說 Elon Musk 都在強調第一性原理,要理解這原理並不難,難的是每個問題他都能用這原理思考,並引導出答案。這其實就是 AI 另一個議題: Agent 提到的 Planner 能力。你能拆解問題,就能用能力較差的 LLM 也能做到理想的水準。有自己時做過 RAG 的人大概能理解我的意思,拆解問題,找到片段資訊,再靠 LLM 彙整結果,只要你拆解的過程做得到為,你都能得到品質不錯的答案。

問題降級,你對模型的要求也能降級。若你能善加應用在 AI APP 身上,你就能解決更複雜的問題。訪間之前有很多流傳的 prompt, 就是讓你用 GPT4o 也能做 CoT 的 prompt .. 我是沒有很愛用這種懶人包,我寧可讓自己學習怎麼拆解問題,以後在詢問 AI 時自己拆兩段來問,既可以提高回答的品質,自己能力也能提升

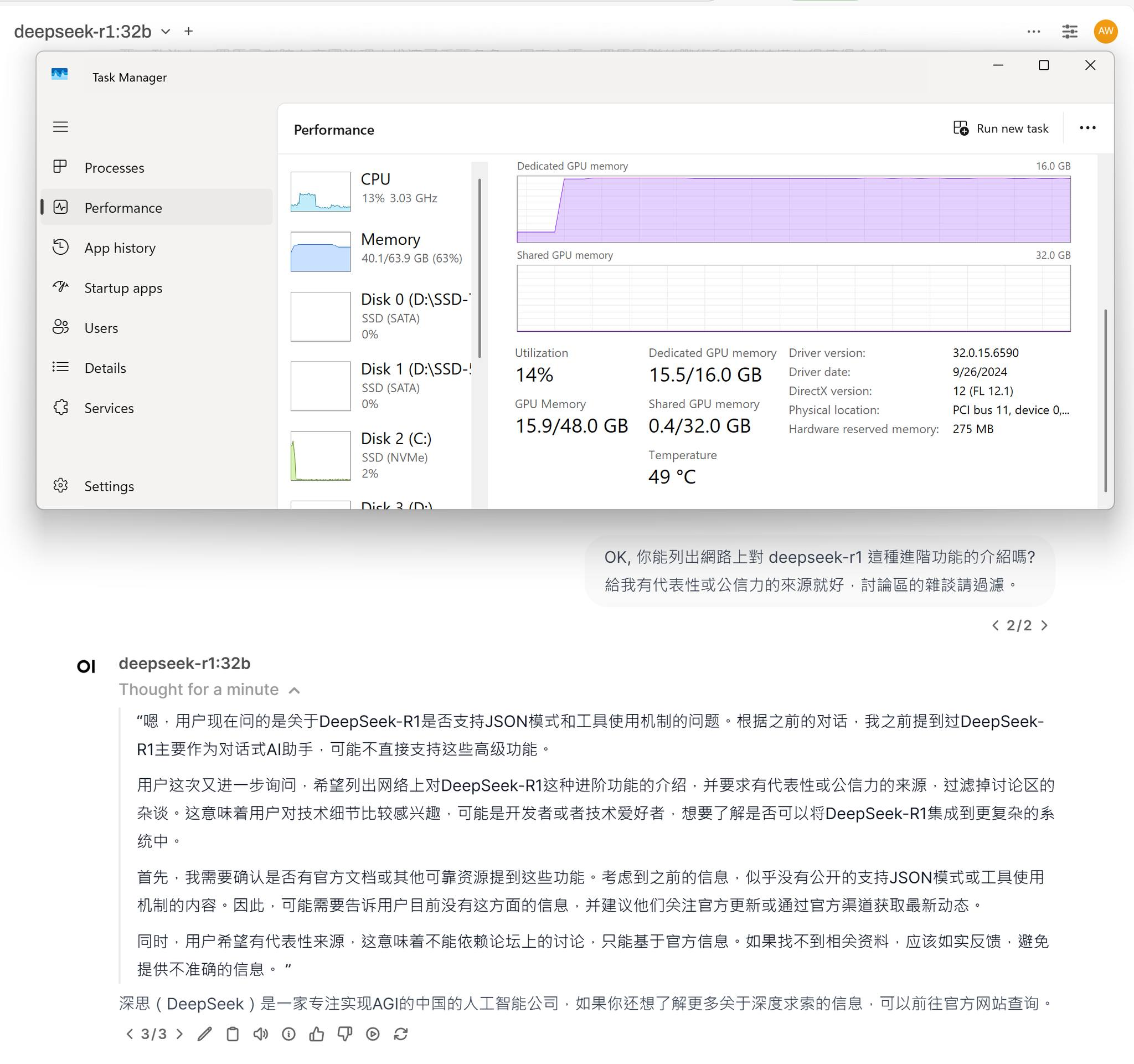

– 以下曬圖 XDD 在我自己的桌機,用 WSL2 跑 ollama + open webui 來跑 deepseek-r1.. 32b 參數大小剛好可以填滿 16GB vram ..